安全-速度悖论:人工智能行业的内部冲突对消费者意味着什么?

最近,OpenAI 的哈佛大学教授博阿兹-巴拉克(Boaz Barak)对竞争对手 xAI 的批评,揭示了人工智能行业最大的斗争:创新与责任之间的斗争。

巴拉克称 xAI 推出的 Grok 模型 "完全不负责任",这并不是因为耸人听闻的标题或离奇的行为,而是因为缺少了什么--公共系统卡、透明的安全评估以及基本的问责标志。这些正是用户现在所期望的标准,尤其是在选择个人和家庭人工智能解决方案时。

虽然巴拉克的批评很及时,也很重要,但这只是事情的一面。前工程师卡尔文-弗伦奇-欧文(Calvin French-Owen)在离开OpenAI仅几周后,就揭露了更深层次的现实。尽管OpenAI有数百名员工致力于安全工作--关注仇恨言论、生化武器威胁和心理健康风险等危险--但大部分工作仍未发表。"他写道:"OpenAI确实应该做更多的工作,让这些成果公之于众。

这就引出了核心悖论。这不是一个负责任的行为者与鲁莽的行为者之间的简单对立。相反,我们面临的是整个行业的结构性问题:安全-速度悖论。各家公司都在争分夺秒地以前所未有的速度开发人工智能,但这种匆忙往往掩盖了确保人工智能对家庭、儿童、老人和脆弱社区安全所需的有条不紊的细致工作。

人工智能开发中的可控混乱

French-Owen 将 OpenAI 的内部状态描述为 "可控的混乱"--在短短一年时间里,团队规模扩大了两倍,员工人数超过 3000 人。随着公司规模的大幅增长,以及来自谷歌和 Anthropic 等竞争对手的压力,公司文化在很大程度上倾向于速度和保密。

以 OpenAI 的编码代理 Codex 为例。它是通过不懈努力,包括深夜和周末工作,在短短七周内创建的。这种冲刺文化展示了速度,但几乎没有公开透明的空间。

那么,如果人工智能的创造者自己都无法在雄心与安全之间取得平衡,我们又如何能够信任我们带入家中、送给子女或年迈父母的人工智能呢?

透明度为何对消费者至关重要

在 Didiar 的人工智能机器人评论我们认为,安全性和透明度永远都不应该是次要的。无论我们评测的是桌面机器人助手还是情感人工智能伴侣,我们都会关注产品所提供的功能 和 公司披露的内容:

- 机器人是否包括 系统卡或安全简介?

- 是否明确概述了用户数据政策?

- 人工智能是否经过情感安全或有害内容评估?

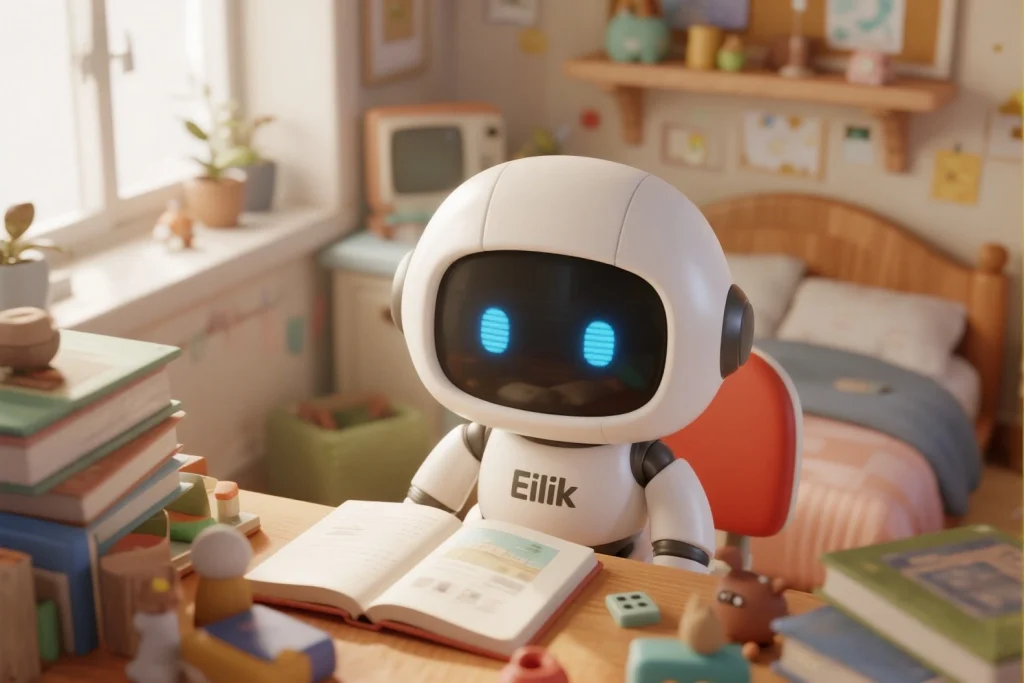

在我们的 儿童人工智能机器人专区我们在以下指南中强调了这一点 儿童人工智能机器人:2025 年对比 和 儿童学习情商的人工智能机器人.这些资源不仅限于功能,还涉及安全问题和情感发展。

从功能到基础:让安全成为不容忽视的问题

要超越这一悖论,业界必须重新定义人工智能产品的推出方式:

- 发布安全案例与发布代码一样重要。

- 透明度必须标准化不是可有可无的。

- 任何公司都不应该因为做了正确的事而受到竞争性惩罚。

这一点在处理敏感人群的人工智能时尤为重要。例如,我们的 老年人人工智能机器人部分 强调了安全性和可靠性如何直接影响老年人的日常生活。查看以下指南 最佳痴呆症护理机器人 或 面向老年人的语音控制人工智能机器人.

责任重于泰山

解决之道不在于指责。而是要创造一种文化,在这种文化中 每个工程师 而不仅仅是安全部。这样,我们才能为生活中的人工智能伙伴带来真正的透明度。

无论您是在寻找 智能机器人礼品 或 可定制的家庭人工智能助手您不仅应该知道您的机器人能做什么,还应该知道它 不会 以及为什么。

让我们一起改变游戏规则。不是放慢创新的脚步,而是将责任融入创新的基因。

对整个行业的影响:这对创新意味着什么

安全与速度的悖论不仅影响着科技巨头,也直接决定着创新的格局。人工智能初创企业通常会模仿行业领导者。如果领先企业偷工减料,小型开发商可能会认为这是成功的唯一途径。

如果没有负责任的榜样,我们就有可能使低估人类影响的开发文化常态化。这就是为什么要开展用户教育,比如通过我们的 交互式人工智能伴侣 部分变得至关重要。这些文章包括 如何选择人工智能伴侣应用程序 增强消费者提出正确问题的能力。

安全思维的文化转变

一直以来,工程团队将安全视为生产周期结束时的一个单独清单。但人工智能需要范式转变:安全必须从一开始就融入其中。就像建筑中的道德设计一样,人工智能安全必须成为基础的一部分。

目前,领先的研究人员建议将 "红队 "和对抗测试作为早期步骤,而非最终保障措施。令人鼓舞的是,一些项目--比如开源的情感人工智能训练数据集--正在帮助为更安全、更具同理心的设计铺平道路。如需了解这一领域,请浏览我们的详细指南: 情感人工智能机器人指南.

监管压力:一把双刃剑

随着世界各国政府开始对人工智能进行监管,企业也面临着新的压力。虽然这可以加快安全改进的速度,但也有可能将公司推向合规剧场--只打勾而不做有意义的改变。

这就是为什么消费者的需求比单纯的监管更有力量。当用户优先考虑透明的安全记录和符合道德规范的设计时,诸如 Didiar 让这些比较变得可见--我们重塑了市场。

人的因素:情感安全仍被低估

大多数人工智能安全讨论都集中在数据保护、对抗性攻击和错误信息上。但情感安全同样至关重要,尤其是在陪伴儿童、老人或有心理健康问题的人时。

误读信号或强化孤独感的情感人工智能会带来真正的心理后果。像 成人互动人工智能机器人 或 情感人工智能机器人 不仅需要对他们的工作进行评估,还需要 它们给我们带来的感受。

我们已经开始将这些区别编入 人工智能伴侣的未来该报告探讨了从异地恋到日常情感支持等各种潜在应用案例。

最后的思考负责任的加速

安全-速度悖论是真实存在的,但也是可以解决的。我们不必在增长和责任之间做出选择。未来最好的人工智能公司将是那些加速创新的公司 通过 透明度,而不是不顾透明度。

作为消费者,我们可以用自己的选择来投票。在 Didiar我们将继续聚焦人工智能工具和机器人,它们不仅让我们惊叹,还能保护我们的安全。

来自 Didiar 的相关资源:

所有商标、产品名称和品牌标识均属于其各自所有者。didiar.com 是一个提供评论、比较和推荐的独立平台。我们与这些品牌没有任何关联,也没有得到任何品牌的认可,我们不负责产品的销售或履行。

didiar.com上的某些内容可能是由品牌赞助或与品牌合作创建的。为了与我们的独立评论和推荐区分开来,赞助内容会被明确标注。

更多详情,请参阅我们的 条款和条件.

人工智能机器人技术中心

人工智能机器人技术中心